L’essor des petits et moyens modèles de langage dans l’IA

L’intelligence artificielle (IA) a connu des avancées rapides ces dernières années, notamment grâce aux grands modèles de langage (LLM) comme GPT-3 et GPT-4 d’OpenAI. Cependant, une nouvelle tendance émerge : les petits et moyens modèles de langage (SLM), conçus pour être plus économiques, rapides et spécialisés. Cet article explore l’importance croissante de ces modèles, leurs avantages et leur impact potentiel sur divers secteurs.

Le passage des grands aux petits modèles

Le plateau de performance des LLM

Des études récentes montrent que les améliorations de performance des grands modèles de langage commencent à atteindre un plateau. Les comparaisons entre les modèles les plus performants comme GPT-4, Claude 3 Opus et Gemini Ultra révèlent des différences minimes en termes de précision pour certaines tâches spécifiques. Cette observation suggère que l’augmentation de la taille du modèle n’entraîne pas nécessairement des gains de performance significatifs.

Efficacité et accessibilité

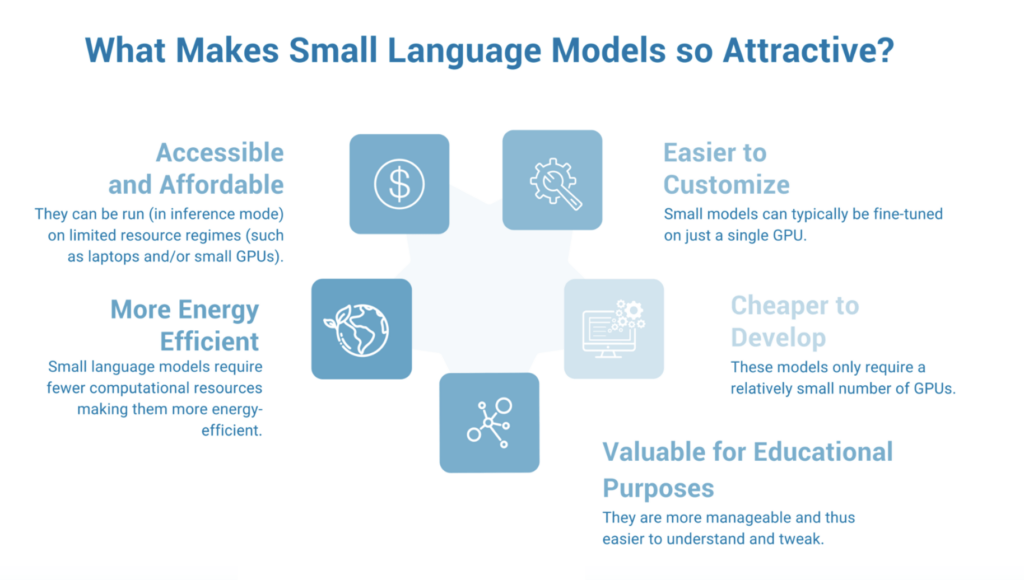

L’un des principaux avantages des SLM est leur efficacité. Ces modèles plus petits nécessitent moins de puissance de calcul, ce qui se traduit par des temps de traitement plus rapides et une consommation d’énergie réduite. Cette efficacité se traduit par des coûts opérationnels plus faibles, rendant les capacités avancées de l’IA accessibles à un plus large éventail d’organisations, y compris les startups et les petites entreprises.

Avantages des petits et moyens modèles de langage

Rentabilité

Les SLM sont considérablement plus abordables que leurs homologues plus grands. La réduction des besoins en calcul et en énergie pour ces modèles se traduit par des coûts de formation et de déploiement plus faibles. Cette accessibilité financière ouvre de nouvelles possibilités pour les organisations qui ne pouvaient auparavant pas justifier les dépenses liées aux systèmes d’IA à grande échelle.

Flexibilité et spécialisation

Les modèles plus petits offrent une plus grande flexibilité en termes d’intégration et d’application. Ils peuvent être adaptés à des tâches spécifiques, telles que la catégorisation de contenu, l’analyse de données ou le support client automatisé. Cette spécialisation permet aux organisations de déployer des solutions d’IA précisément alignées sur leurs besoins opérationnels, améliorant ainsi la productivité et l’efficacité.

Meilleure interprétabilité

Contrairement aux grands modèles d’IA qui fonctionnent souvent comme des “boîtes noires”, les modèles plus petits sont plus interprétables. Cela permet aux développeurs de mieux comprendre et ajuster les paramètres qui influencent le comportement du modèle. Cette meilleure interprétabilité est cruciale pour créer des systèmes d’IA fiables et dignes de confiance.

Applications des petits et moyens modèles de langage

Informatique de pointe

Les SLM sont particulièrement adaptés à l’informatique de pointe, où les données sont traitées localement sur les appareils plutôt que de s’appuyer sur une infrastructure cloud centralisée. Cette approche réduit la latence, améliore la confidentialité des données et améliore l’expérience utilisateur. Des secteurs tels que la finance, la santé et l’automobile bénéficient de solutions d’IA en temps réel, personnalisées et sécurisées rendues possibles par les SLM.

Solutions spécifiques à l’industrie

Les SLM peuvent être personnalisés pour des applications spécifiques à l’industrie, offrant des solutions ciblées qui répondent à des défis uniques. Par exemple, dans le domaine de la santé, les SLM peuvent aider au diagnostic de conditions médicales en analysant les données des patients et la littérature médicale. Dans le secteur financier, ils peuvent améliorer la détection des fraudes en identifiant des schémas inhabituels dans les données de transaction.

Défis et orientations futures

Qualité des données et formation

Bien que les SLM offrent de nombreux avantages, leurs performances dépendent fortement de la qualité des données d’entraînement. Des ensembles de données de haute qualité et diversifiés sont essentiels pour former des modèles capables de bien généraliser dans différents scénarios. De plus, le développement de stratégies de formation efficaces qui maximisent les capacités des modèles plus petits reste un domaine de recherche crucial.

Équilibre entre taille et capacité

Trouver l’équilibre optimal entre la taille du modèle et ses capacités reste un défi permanent. Les chercheurs explorent diverses techniques, telles que la distillation des connaissances et l’apprentissage par transfert, pour améliorer les performances des modèles plus petits sans augmenter significativement leur taille. Ces approches visent à capturer les “ingrédients minimaux” nécessaires à un comportement intelligent, permettant le développement de systèmes d’IA compacts mais puissants.

Conclusion

Le passage aux petits et moyens modèles de langage représente une évolution significative dans le domaine de l’IA. Ces modèles offrent une combinaison convaincante d’efficacité, d’accessibilité financière et de spécialisation, ce qui en fait une alternative attrayante à leurs homologues plus grands. Alors que la communauté de l’IA continue d’explorer le potentiel des SLM, nous pouvons nous attendre à voir des applications et des solutions innovantes qui démocratisent l’accès aux capacités avancées de l’IA. En se concentrant sur des modèles plus petits et plus interprétables, les chercheurs et les développeurs ouvrent la voie à un avenir de l’IA plus durable et inclusif.